ל-AI יש בעיה: הצ'טבוט מחפש כיוון - גדול יותר כבר לא טוב יותר

ל-AI יש בעיה: הצ'טבוט מחפש כיוון - גדול יותר כבר לא טוב יותר

כש־OpenAI השיקה את ChatGPT לציבור הרחב לפני כשנתיים, היא הדהימה את העולם ביכולות השיחה של הצ'טבוט, ועוררה חשש אמיתי מפני עתיד שבו בינה מלאכותית (AI) יכולה לאיים על עצם קיום האנושות. חששות אלו רק התחזקו במרץ 2023, עם ההשקה של GPT–4, מודל השפה הגדול (LLM), שהזניק את יכולות ChatGPT בכמה וכמה רמות. "בלימת הסיכון של היכחדות האנושות על ידי AI צריכה לעמוד בראש סדר העדיפויות העולמי", הזהירו חודשיים מאוחר יותר בכירים בתחום ה־AI, ובראשם מייסד ומנכ"ל OpenAI סם אלטמן.

ואז קרה משהו מפתיע: שום דבר דרמטי לא קרה. שחקניות אחרות כמו גוגל ואנטרופיק השיקו מודלים שמשתווים או קרובים ביכולותיהם ל־GPT–4. חברת OpenAI הציגה שדרוגים בדמות GPT–4o. אבל פריצת הדרך הבאה, מודל LLM חדש שיביא את הזינוק הבא בתחום ויקרב את הרגע שכולם כה חששו ממנו – לא הגיעה. השיטות ששימשו את חברות הבינה המלאכותית הגנרטיבית (GenAI) לייצר את פריצות הדרך הגדולות של השנים האחרונות לא מצליחות להזניק את התחום לרמה הבאה.

שיפור "קטן בהרבה"

הדבר מאלץ חברות לפתח שיטות חדשות לשיפור היכולות של מודלים קיימים, והחלפת המיקוד הזו יכולה לבשר על שינויים רוחב שיכולים אפילו לגדוע את הצמיחה המטורפת שרשמה אנבידיה בשנתיים האחרונות בעקבות הביקוש האדיר לשבבי ה־AI שלה.

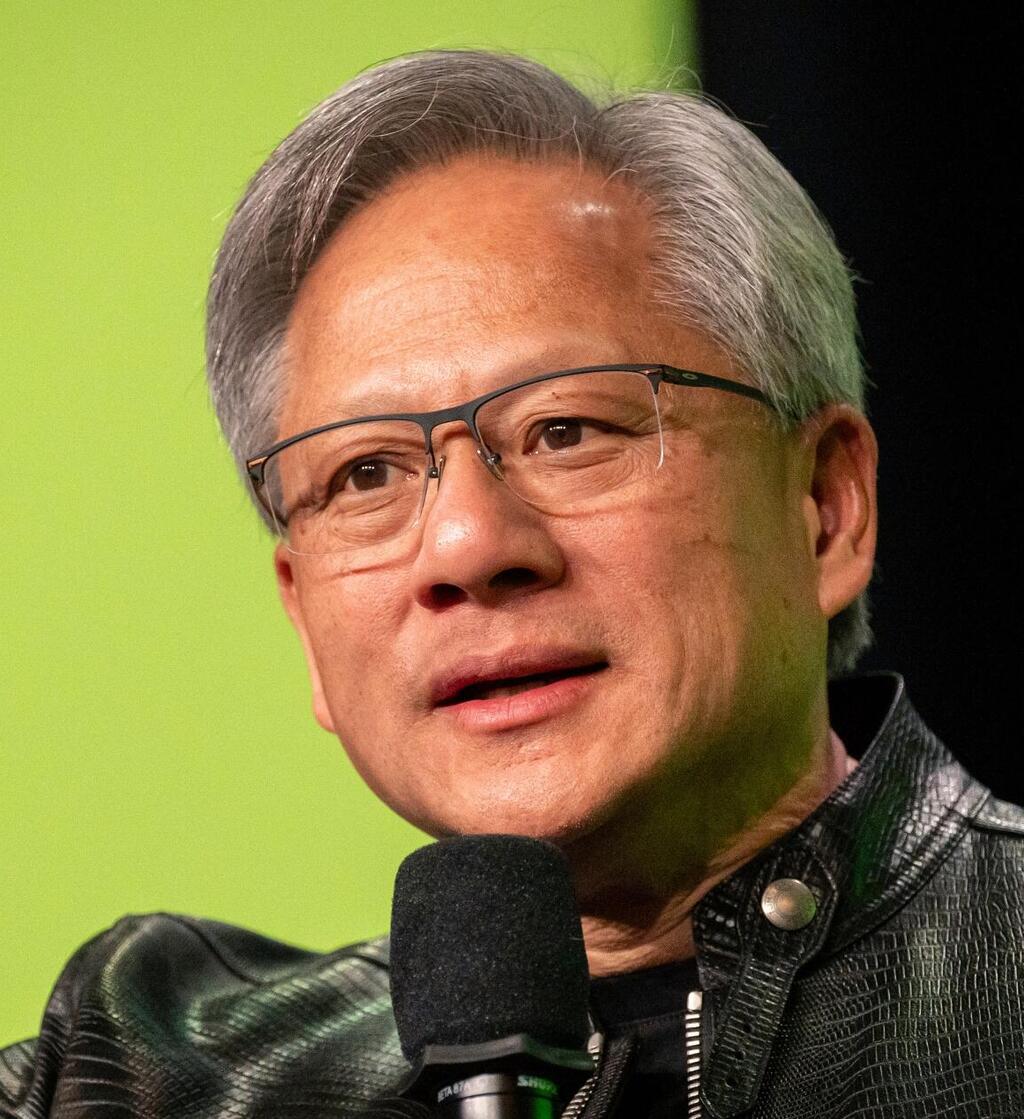

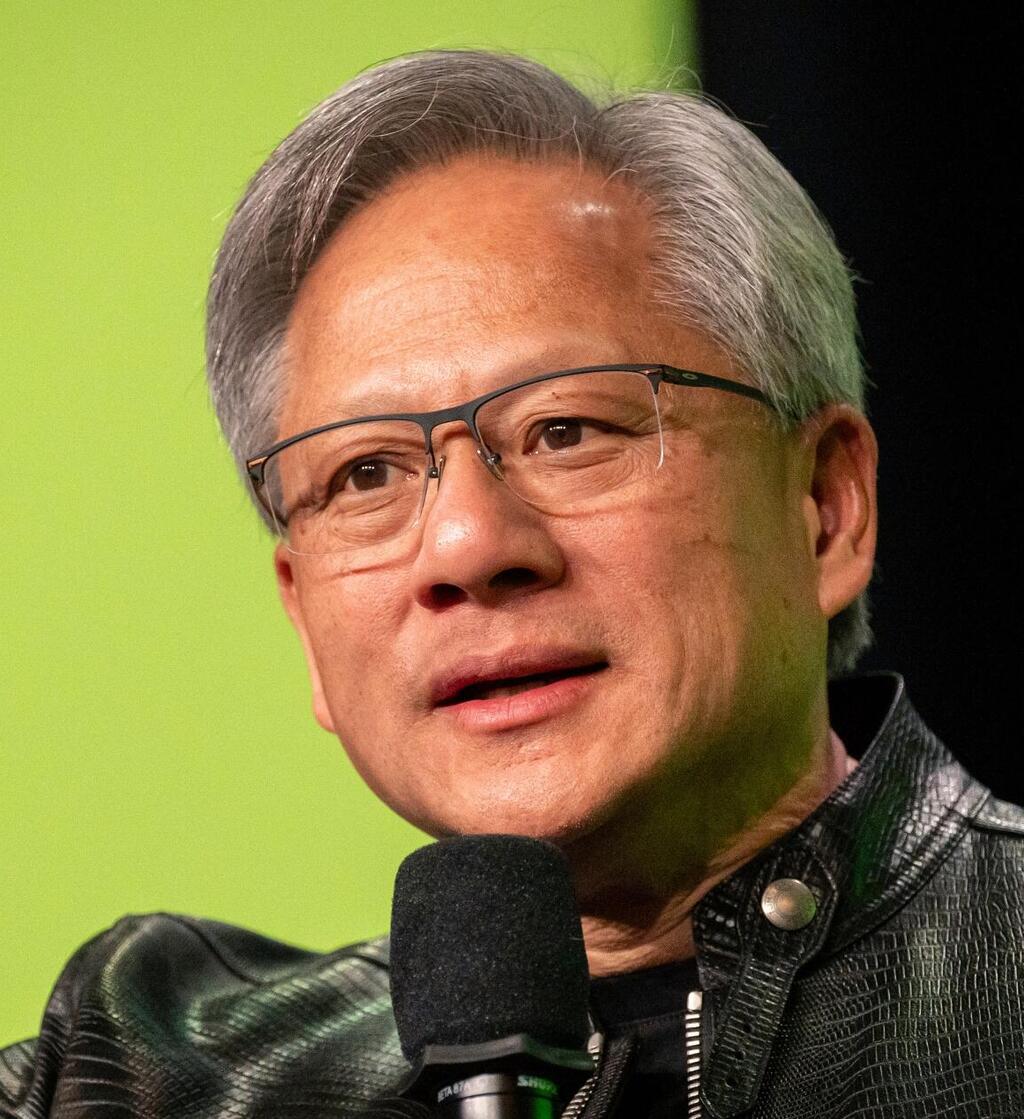

4 צפייה בגלריה

מנכ"ל אנבידיה ג'נסן הואנג. השינוי שעוברים מודלי ה־AI יכול לגדוע את הביקוש האדיר לשבבי ה־AI שלה

(צילום: David Paul Morris/Bloomberg)

לפי דיווח של רויטרס, חוקרים במעבדות AI מובילות נתקלים בעיכובים ובתוצאות מאכזבות במירוץ לפתח את ה־LLM הבא שיעלה בביצועיו על GPT–4. אתר The Information דיווח ש־OpenAI נתקלה בקשיים בפיתוח אוריון (Orion), היורש של GPT–4. לדברי עובדים בחברה, השיפור בביצועים שמספק אוריון "קטנים בהרבה" לעומת המעבר מ־GPT–3 ל־GPT–4.

"אוריון לא טוב יותר בצורה אמינה מ־GPT–4 בטיפול במטלות מסוימות", אמרו חוקרים בחברה לאתר Techradar. מטלות אלו כוללות כתיבת קוד תוכנה, שם לא מצליח אוריון להציג יכולות משופרות. מנגד, מדווח, כישורי השפה של המודל חזקים בהרבה.

אחד הקשיים נעוץ בירידה בהיקף האספקה של טקסטים ומידע אחר באיכות גבוהה שנחוץ לאימון המודל. GPT–4 ובני דורו אומנו על כמויות אדירות של מידע, כמעט כל מה שזמין בצורה חופשית ברשת ומקורות נוספים מעבר לכך. למודלי הדור הבא אין הרבה יותר מקורות חדשים לגשת אליהם, ולכן בסיס המידע שעליו הם מאומנים לא שונה בהרבה ממודלי הדור הנוכחי. הקושי למצוע מידע אימון באיכות גבוהה פוגע משמעותית ביכולת לשפר את יכולות המודלים החדשים לעומת הקיימים.

4 צפייה בגלריה

סם אלטמן, מייסד ומנכ"ל OpenAI. החברה נתקלה בקשיים בפיתוח אוריון (Orion), היורש של GPT–4

(צילום: Jason Redmond / AFP)

לכך מתווספות בעיות טכניות שנובעות מגודל וממורכבות המודל. אימון המודלים כרוך בעלויות של עשרות מיליוני דולרים, שדרושים על מנת לרכוש ולהריץ את מאות שבבי ה־AI שמשמשים במטלה. מערכות החומרה שמפותחות לצורך כך הן גם מורכבות יותר, ולכן חשופות יותר לכשלים שונים. במקרים מסוימים, לפי רויטרס, סבלו חברות ממחסור באנרגיה שדרושה לצורך הפעלת מערכי החומרה האלו.

4 צפייה בגלריה

סם אלטמן, מייסד ומנכ"ל OpenAI. החברה נתקלה בקשיים בפיתוח אוריון (Orion), היורש של GPT–4

(צילום: אביגיל עוזי)

לדברי איליה סוצקבר, ממייסדיי OpenAI שפרש מהחברה מוקדם יותר השנה והקים את Safe Superintelligence)), שיטת האימון הנוכחית של מודלי שפה גדולים כבר לא מביאה לגידול משמעותי בביצועי המודלים, והתפיסה של גדול יותר הוא טוב יותר הגיעה למגבלותיה. "שנות העשרה של המאה ה־21 היו סביב הגדלת קנה המידה של הפעילות", אמר לרויטרס. "עכשיו חזרנו שוב לעידן הפליאה והגילוי. כולם מחפשים את הדבר הבא. מיקוד בהגדלת קנה המידה של הדברים הנכונים חשוב יותר מתמיד". הוא הוסיף שהחברה שלו מפתחת שיטת אימון חלופית, אך סירב לפרט מעבר לכך.

סוף המרוץ אחר שבבי AI?

לאור האתגרים באימון מודלים חדשים, מתמקדות חברות בשיטות לשיפור המודלים הקיימים. אחת מהן, שמכונה test־time compute, מאפשרת לשפר את יכולותיו של מודל קיים בזמן השימוש בו. לדוגמה, במקום לספק מיידית מענה אחד לשאלה, המודל מייצר מספר תשובות אפשריות ובוחר מביניהן את הטובה ביותר. "מסתבר שאם מאפשרים לבוט לחשוב במשך 20 שניות, זוכים לשיפור בביצועים זהה לו היינו משתמשים במודל גדול פי 100 אלף ומאמנים אותו פי 100 אלף יותר זמן", אמר לאחרונה נעם בראון, חוקר ב־OpenAI, בוועידת TED AI בסן פרנסיסקו.

החברה יישמה את הטכניקה הזו במודל o1 שחשפה בספטמבר. מודל זה מסוגל לפתור בעיות מורכבות יותר, לנתח תשובות ולבחון אסטרטגיות שונות באמצעות הקדשת זמן רב יותר ל"מחשבה" לפני שהוא משיב לשאילתה. לדברי החברה, הדבר מאפשר לו לספק ביצועים משופרים במטלות כמו תכנות, מתמטיקה והיסק מדעי. מקורות עם ידע בנושא אמרו לרויטרס שחוקרים באנטרופיק, דיפמיינד של גוגל ו־xAI של אלון מאסק מפתחים גרסאות משלהם לשיטה זו.

למעבר הזה יכולות להיות השלכות רוחביות בתחום ה־AI ומחוצה לו. בשנתיים האחרונות, למשל, התאפיין שוק ה־AI במרוץ מטורף אחר שבבי AI, במיוחד אלו של אנבידיה, שדרושים לאימון המודלים השונים. הבנה שיותר כוח עיבוד לא מיתרגם למודלים טובים יותר, ומעבר לשיטות שיפור אחרות שלא דורשות כוח עיבוד רב כל כך, יכולה להביא לצניחה בביקוש האדיר לשבבים של אנבידיה, בין אם כי אין לחברות צורך בכוח עיבוד רב כל כך ובין אם כי המיקוד יעבור משבבי AI לאימון מודלים לשבבים שמשמשים להרצתם — תחום שבו חברות שבבים כמו אינטל נמצאות בעמדה תחרותית טובה הרבה יותר.