משפט שדההעתיד כבר כאן: מעצר וחיסול בידי האלגוריתם

משפט שדה

העתיד כבר כאן: מעצר וחיסול בידי האלגוריתם

המשטרה והצבא מפעילים מערכות AI שקבעו מי ייעצר לבדיקת סמים בנתב"ג וכאלה שמאבחנות מי בעזה יחוסל. הן פועלות כ"קופסה שחורה" שמקשה על ביקורת שיפוטית, ובניגוד לאירופה, הגישה היא הפעלה ללא הסמכה מפורשת

1. AI קובעת מי עבריין

והשוטרים אינם יודעים לנמק מדוע הם עוצרים את האזרח

האם הגענו לעידן שבו המכונה תעצור חשודים ולא השוטר? האם המכונה תהיה זו שתזהה מחבלים שיוצאו להורג? ובכן, אנחנו כבר בעידן הזה. מערכות בינה מלאכותית מסייעות לתפיסת סוחרי סמים בנתב"ג ולהפללת חמאסניקים בעזה. אבל לא באמצעים המסורתיים של חשד פרטני ממוקד מודיעינית אלא לפי מודל הסתברותי סטטיסטי. "דמיינו לכם עולם שבו שוטרים נשלחים לעצור חשוד בביצוע פשע, אבל לא בגלל שקיים נגדו חשד סביר, אלא בשל אינדיקציה של מערכת AI שמנבאת שייתכן שהוא העבריין", אומר עו"ד גיל גן־מור, מנהל היחידה לזכויות אזרחיות וחברתיות באגודה לזכויות האזרח. "השוטרים אינם יודעים לנמק מדוע הם עוצרים דווקא את אותו אזרח מעבר להמלצת המערכת. אם בעבר זה היה קיים רק בסרטים בכיכובו של טום קרוז - היום זאת כבר המציאות. גם במשטרת ישראל".

2. שימוש במחשכים

בית המשפט: לא ניתן לבחון אילו נתונים נלקחו בחשבון בהחלטה

גן־מור דיבר בכנס העמותה למשפט ציבורי שנערך בסוף השבוע. הוא סקר שתי מערכות כאלה, משטרתית וצבאית. "המשטרה", סיפר, "עשתה שימוש, במחשכים, במערכת AI לניבוי מבריחי סמים בנתב"ג. אפילו לא המתינו להסמכה בחוק". על מערכת ההכללה (פרופיילינג) בנתב"ג, שנחשפה בכלכליסט, סיפר גן־מור: "מהמידע שנחשף למדנו שהמערכת מייצרת פרופיל סטטיסטי שעשוי לנבא מעורבות בבלדרות סמים, פרופיל שנבנה על ידי איתור קשרים בנתונים רבים שמוזנים במערכת, לרבות דפוסי בלדרות מהעבר וכן מאגרי מידע משטרתיים. המערכת סוקרת את כל הבאים בשערי המדינה, ובוחנת האם הם תואמים לפרופיל. הפלט שלה הוא המלצה לעכב את האזרח ולבצע בו חיפוש מלא לסמים. השוטרים במשמרת אינם מסוגלים לדעת מדוע אדם מסוים מעוכב על ידיהם. זה מה שהמחשב אמר, ויש לסמוך על המערכת".

השופט עידו דרויאן־גמליאל בבית המשפט המחוזי במחוז מרכז מצא כי מדובר במערכת שעובדת כקופסה שחורה, שהפלט שלה הוא תוצר של למידת מכונה, וכי לא ניתן לבחון, גם לא בדיעבד, אילו נתונים נלקחו בחשבון ואיזה משקל ניתן להם. בית המשפט ציין כי מצב דברים זה שולל אפשרות לביקורת שיפוטית. "בעקבות זאת", סיפר גן־מור, "הגשנו באגודה לזכויות האזרח עתירה לבג"ץ, שדרשה לאסור על המשטרה לעכב אזרחים לחיפוש סמים בהתבסס על מערכת ה־AI. "למיטב ידיעתי", אמר, "זאת היתה העתירה הראשונה שהוגשה עד כה בעניין הסמכות לעשות שימוש במערכות בינה מלאכותית בשירות רשויות השלטון". בג"ץ מחק את העתירה לאחר שהמשטרה הודתה שהשימוש במערכת הופסק בשנת 2022 ושאין כוונה להשיב את המערכת לשימוש.

3. המערכת מפלילה

ויש הסתמכות כמעט אוטומטית על המלצותיה, בשאלות של חיים ומוות

הצבא עשה שימוש במערכת לבנדר שנחשפה השנה בלחימה בעזה. לבנדר היא חלק ממערכת שמכונה “הבשורה” ופותחה ב־2021 כדי להאיץ ולייעל את הליך ההפללה של יעדים. גן־מור שוב פונה לדמיון ומחבר אותו למציאות: "דמיינו עולם שבו החלטות על חיים ומוות במובן הכי מילולי של המילה מתקבלות בקצב מסחרר על ידי מערכת בינה מלאכותית. זה לא סרט עתידני. לפי הצבא, הלבנדר מוזנת במגוון רחב של מקורות מודיעיניים, אלקטרוניים, אנושיים, גלויים וכדומה. מטרתה לנבא מי הוא פעיל חמאס ומי לא".

המערכת, לפי תחקיר של העיתונאי יובל אברהם באתר "שיחה מקומית", בנתה פרופיל של פעיל חמאס ואז היא מאתרת דפוסי התנהגות או מאפיינים דומים בכלל האוכלוסייה העזתית ומדרגת את ההסתברות שאזרח מסוים הוא פעיל באחד מארגוני הטרור. וגם כאן הפלט מסמן את החשודים ומנבא מי פעיל טרור. "הצבא עבר משיטה של ניתוח מודיעין באופן פרטני להסתמכות על הערכה שמבוססת על פרופיילינג ודירוג של פעילות אנושית", אמר גן־מור והוסיף: "מצד אחד, המערכת מלמדת שנעשה ניסיון לכבד את עקרון ההבחנה, ולהימנע מפגיעה באזרחים. מצד שני, ההסתמכות על AI מעוררת שורה של שאלות משפטיות ומוסריות כבדות משקל. למשל, לא ברור עד כמה ראוי להשתמש בבינה מלאכותית לייצור פרופיילינג המבוסס על התנהגות אנושית, ולא על מידע מדיד כמו נתונים של בדיקות דם. האם אין מדובר פה במדרון חלקלק לעבר מערכות לדירוג חברתי?".

היתרון הגדול במערכת הוא המהירות העל־אנושית של איסוף מודיעין על פעילים בדרגים יותר זוטרים. לפי מידע שהושג ממקורות שונים, סיפר גן־מור, המערכת סימנה 37 אלף בני אדם כפעילים בחמאס או בג'יהאד.

השימוש בלבנדר היה הצצה בזמן אמת לשאלת ההסתמכות על AI להחלטות שלטוניות של חיים ומוות. "הצבא טען במענה לבקשת המידע שלנו שכל יעד שהמערכת ממליצה להפליל עובר בחינה על ידי חוקר מודיעין שיכול להבין את הסיבות להפללה שביצעה המערכת", אמר גן־מור. אלא שהמקורות ששוחחו עם "שיחה מקומית" הציגו תמונה שונה לגמרי: אנשי מודיעין דיווחו שהיו תחת לחץ לאשר עוד ועוד מטרות; שניתן להם זמן של כמה שניות לבחינת כל יעד; והנחיה רק לוודא שמדובר בגבר ולא באשה. זה מצביע על הסתמכות כמעט אוטומטית על המלצות המערכת. "באפריל 2024 פנינו ליועצת המשפטית לממשלה לפתוח בבדיקה עצמאית של השימוש במערכות AI במלחמה", אמר גן־מור, שהצביע על הצד המטריד ביעילות הזו שמאפשרת "פגיעה בהיקפים וקצב חסרי תקדים, שההסתמכות על המערכת רידדה לחלוטין את עקרון האבחנה ואת עקרון המידתיות וגם את עקרון הזהירות". היועצת טרם השיבה לפנייה.

4. פגיעה בזכויות

לצד תרומה אדירה, המערכות עלולות לפגוע בשוויון ובפרטיות

אלה שתי דוגמאות של שילוב הבינה המלאכותית בהפעלת הכוח השלטוני. המערכות בנויות על למידה עצמאית של נתוני עתק ואיתור דפוסים, שעין אנושית מתקשה לזהות. הפלט שהן מייצרות הוא החלטה או המלצה לפעולה. ניתן לומר שהאלגוריתם הוא זה שעוצר ומפליל ולא השוטר החוקר. הן נכנסות עתה לשימוש במשטרה, בצבא ולא רק – גם במערכות המשפט, הרווחה והבריאות. הן עשויות להביא לתרומה אדירה לאנושות, אך הן עלולות להוביל לפגיעה קשה בזכויות אדם.

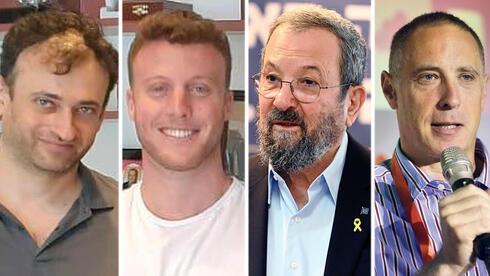

1 צפייה בגלריה

עו"ד גיל גן־מור מהאגודה לזכויות האזרח. "ההסתמכות על AI מעוררת שורה של שאלות משפטיות ומוסריות כבדות משקל"

(צילום: אסף פינצוק)

ואין כמו גן־מור כדי למנות אותן: פגיעה בעקרון החוקיות, בהפעלת שיקול הדעת, בביקורת השיפוטית, בזכות לפרטיות, בזכות לשוויון. למה בשוויון? "יש כבר די הרבה ראיות שהמערכות הללו עשויות להפלות או להנציח הפליה", אומר גן־מור ומסביר את מה שדובר בו לא מעט: "מערכות AI לזיהוי פנים נרכשות על ידי משטרות וגופי מודיעין בעקבות הבטחות לאחוזי דיוק גבוהים במיוחד. אלא שהתברר שההסתברות שמערכות לזיהוי פנים יהיו מדויקות יורדת פלאים כאשר התמונה היא לא באיכות גבוהה או מזווית או בצל. עוד התברר שההסתברות יורדת כאשר מדובר בבעלי צבע עור כהה לעומת צבע עור בהיר, או נשים לעומת גברים. מכיוון שהמשטרה לא עובדת בתנאי מעבדה, אין זה מפתיע שמעצרים שנעשו על בסיס מערכת זיהוי פנים הובילו בארה"ב למעצר שגוי, בעיקר של שחורים".

5. פה זה לא אירופה

חשוב שההסדרה תהיה בידי הרשות המחוקקת ולא המבצעת

גן־מור מסכם את ההבדל בינינו לבין אירופה: "הגישה בארץ היא שלא רק שמערכות טכנולוגיות כאלו לא צריכות הסמכה מפורשת אלא שעדיף להכניסן לשימוש במחשכים, על בסיס סמכויות עזר כלליות. התפיסה הזו מובילה לשחיקה של העיקרון הדמוקרטי שלפיו מי שמוסמכת להתיר פגיעה בזכויות אדם, ולקבוע את ההסדר הראשוני, היא הרשות המחוקקת ולא הרשות המבצעת".

"לעומת זאת, הגישה האירופית שהתבטאה בחוק ה־AI מ־2023 היא הגישה הנכונה בעיניי - נבחרי הציבור הגדירו מה מותר ומה אסור. הם קבעו שיש מערכות בינה מלאכותית שהן אסורות, כמו, למשל, מערכות המבוססות על פרופיילינג, ויש מערכות בסיכון גבוה, הכפופות לשורה ארוכה של מגבלות וחובות. החוק נעשה לאחר דיון ציבורי ממושך. כך צריכה לפעול דמוקרטיה".