איך בדיוק פייסבוק משחקת במוח שלכם, ומסכנת את העולם

פרנסואה שולה, ממומחי הבינה המלאכותית המובילים בעולם, פרסם מאמר חריף שבו הוא מסביר כי הבעיה האמיתית ב־AI היא האופן שבו היא משמשת רשתות חברתיות למניפולציות אפקטיביות על דעותיהם ומעשיהם של בני האדם. באמירה יוצאת דופן הוא קורא לעמיתיו לענף להתנגד למוצרים שעושים זאת, ולבחור בחירות מוסריות גם כשהם מתכנתים ממשקים חכמים. מיוחד למוסף כלכליסט

הסתייגות: אלו הן דעותיי האישיות. איני מייצג את המעסיק שלי. אם בכוונתכם לצטט מן המאמר אנא נהגו ביושר והציגו דעות אלו כפי שהן: דעות אישיות וספקולטיביות, שיש לשפוט אותן לגופן.

כשהמחשבים האישיים החלו להיכנס לחיינו היו לא מעט אנשים שהגיבו בחרדה, בפחד ואף באגרסיביות. בעוד חלק מאיתנו היו מהופנטים מהמחשבים והמומים מהפוטנציאל שזיהינו בהם, רוב האנשים לא הבינו אותם. הם חשו שהמחשב הוא דבר זר, לא ברור ומאיים. אנשים פחדו שהטכנולוגיה תחליף אותם. רובנו הגבנו לשינויים טכנולוגיים באי־נוחות מסוימת במקרה הטוב ובפניקה במקרה הרע. אולי זה קורה עם כל שינוי; אבל רוב מה שאנחנו חוששים ממנו אף פעם לא קורה.

להאזנה לכתבה, הוקלט על ידי הספריה המרכזית לעיוורים ולבעלי לקויות קריאה https://www.clfb.org.il/heb/main/

כעבור כמה שנים, שונאי המחשבים למדו לחיות איתם ולהיעזר בהם. מחשבים לא החליפו אותנו ולא הובילו לאבטלה המונית, וכיום אנחנו לא יכולים לתאר את חיינו ללא לפטופים, טאבלטים וסמארטפונים. השינוי המאיים היה לסטטוס קוו נוח. אבל בעוד החששות ההם לא התממשו, מחשבים ואינטרנט אפשרו איומים שאף אחד לא הזהיר אותנו מפניהם: מעקב המוני מתמיד, האקרים שפורצים לתשתית ולמידע האישיים שלנו, ניכור פסיכולוגי במדיה החברתית, אובדן הסבלנות ויכולת הריכוז שלנו, הקצנה פוליטית ודתית, גורמים עוינים זרים שחוטפים את הרשתות החברתיות כדי לשבש דמוקרטיות.

- פרישת מייסד ווטסאפ מוכיחה: פייסבוק לא מתכוונת להשתנות

- פרשת קיימברידג' אנליטיקה: גם טוויטר מכרה מידע של משתמשים

- מפתחים זועמים על פייסבוק: החברה הכריזה עלינו מלחמה

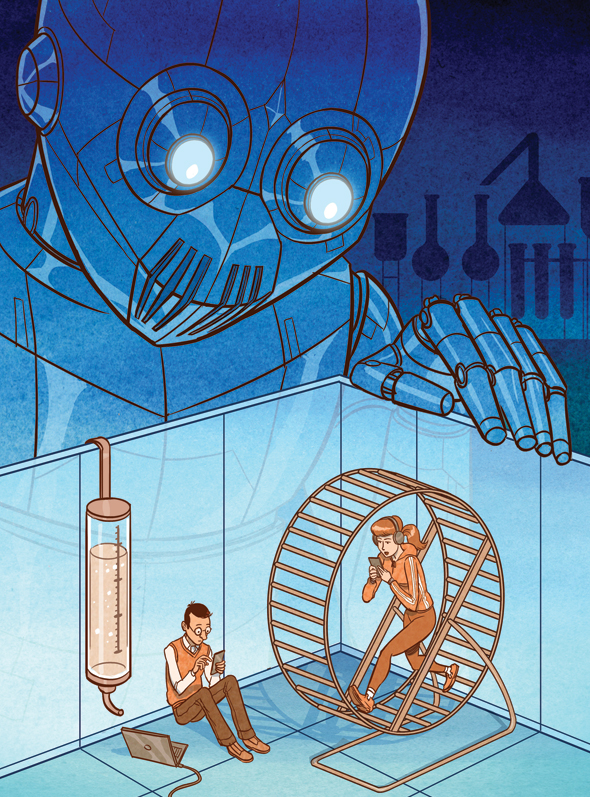

איור: קורן שדמי

איור: קורן שדמי

אם רוב הפחדים שלנו מתבררים כלא רציונליים, הרי שמנגד רוב ההתפתחויות המדאיגות באמת שהולידו שינויים טכנולוגיים נבעו מדברים שרוב האנשים לא חששו מהם כלל. לפני 100 שנה לא באמת יכולנו לחזות שטכנולוגיות התחבורה והייצור שפיתחנו ישמשו בלחימה תעשייתית שתמחק עשרות מיליונים בשתי מלחמות עולם. לא הקדמנו להבין שהמצאת הרדיו תאפשר תעמולה המונית שתסייע לעליית הפשיזם באיטליה ובגרמניה. התקדמות הפיזיקה התיאורטית לא לוותה בכתבות מלאות חרדה על כך שהיא תצמיח נשק גרעיני שיטיל על העולם איום תמידי של השמדה קרבה. כציביליזציה, נראה שאנחנו ממש גרועים בזיהוי נכון של איומי העתיד ובדאגה מוצדקת לגביהם, כפי שאנחנו בהחלט נוטים להיתקף בהלה בשל פחדים לא רציונליים.

כיום, כמו פעמים רבות בעבר, אנו מתמודדים עם גל חדש של שינוי קיצוני: אוטומציה קוגניטיבית, מה שבאופן כללי אפשר לקרוא לו AI, בינה מלאכותית. וכמו פעמים רבות בעבר, אנו חוששים שהטכנולוגיות החדשות האלה יזיקו לנו — שהבינה המלאכותית תוביל לאבטלה המונית, או שתהפוך לישות עצמאית, סופר־אנושית, ותחליט לחסל אותנו. אבל אולי גם הפעם אנחנו חוששים מהדבר הלא נכון, כפי שעשינו בעבר? מה אם הסכנה האמיתית ב־AI רחוקה מאוד מהנרטיבים של "אינטליגנציית־על" ו"סינגולריות" שרבים מבוהלים מהם כעת?

במאמר זה אני רוצה להעלות את המודעות למה שבאמת מדאיג אותי בנוגע לבינה מלאכותית: היא מאפשרת מניפולציות אפקטיביות על ההתנהגות האנושית, ותאגידים וממשלות עושים בה שימוש זדוני. זה אינו הסיכון הממשי היחיד בהתפתחות טכנולוגיות קוגניטיביות, יש רבים אחרים, במיוחד כאלה הקשורים להטיות מזיקות של מודלים של למידת מכונה. בחרתי לכתוב על מניפולציית המונים משום שאני חושב שהיא לא פחות בוערת, אבל זוכה לפחות הכרה.

הסכנה הזאת היא כבר מציאות, ויש כמה מגמות טכנולוגיות ארוכות טווח שיעצימו אותה משמעותית בעשורים הבאים. חיינו נהפכים לדיגיטליים יותר ויותר, וכך גדלה הגישה של חברות המדיה החברתית לחיים שלנו ולמה שמתרחש בתוך ראשינו. במקביל, גדלה הגישה שלהן לווקטורים של שליטה התנהגותית, במיוחד באמצעות הפיד האלגוריתמי ששולט בצריכת המידע שלנו. זה הופך את ההתנהגות האנושית לבעיית אופטימיזציה, או בעיית AI: חברות המדיה החברתית מכווננות את כלי השליטה שלהן ללא הפסקה כדי לגרום למשתמשים להתנהגויות ספציפיות, כפי שבינה מלאכותית שמשחקת במשחק מסוים מכווננת את האסטרטגיה שלה ללא הפסקה כדי לנצח, והנקודות שהיא מקבלת מעניקות לה את הפידבק הנדרש לכוונון הזה. צוואר הבקבוק היחיד בתהליך הזה הוא האינטליגנציה של האלגוריתם, אבל הרשת החברתית הגדולה בעולם כבר משקיעה מיליארדי דולרים במחקר בתחום.

פרנסואה שולה צילום: יוטיוב

פרנסואה שולה צילום: יוטיוב

תנו לי להסביר את זה בפירוט.

פרופילים עם יכולת חיזוי

הרשתות החברתיות כפנאופטיקון

ב־20 השנה האחרונות חיינו האישיים והציבוריים נדדו לאינטרנט, ואנחנו מתקדמים למצב שבו רוב מה שאנחנו עושים יכלול צריכה, עיבוד או יצירה של מידע דיגיטלי. אחת מתופעות הלוואי היא שחברות וממשלות אוספות עלינו כמות מדהימה של מידע, במיוחד באמצעות הרשתות החברתיות. עם מי אנחנו מתקשרים, מה אנחנו אומרים, איזה תוכן אנחנו צורכים, מה מצב הרוח שלנו בכל עת. בסופו של דבר, כל מה שנקלוט וכל מה שנעשה יתועד באיזה שרת מרוחק.

התיאורטית, המידע הזה מאפשר למי שאוסף אותו לבנות פרופילים פסיכולוגיים מדויקים מאוד של יחידים ושל קבוצות. אפשר להצליב את הדעות וההתנהגות שלך עם אלו של אלפי אנשים הדומים לך ולקבל הבנה מדהימה של מה שמפעיל אותך, עם יכולת חיזוי שכנראה תהיה טובה יותר מזו שאתה עצמך תוכל להגיע אליה באמצעות התבוננות בעצמך. המידע הזה מאפשר לחזות שבעוד כמה ימים תתחיל מערכת יחסים חדשה (ועם מי), או מתי תסיים את מערכת היחסים הנוכחית, או מי עלול להתאבד, או למי תצביע בבחירות, גם אם אתה מרגיש שעדיין לא החלטת. וכאמור, זה לא קורה רק ברמת הפרט: הפרופילים על קבוצות גדולות מדייקים בחיזוי אפילו יותר, כי בקבוצות גדולות מתבטלת השפעת הרנדומליות והמקרים החריגים.

ניוזפיד מכוון היטב

מידע דיגיטלי כווקטור שליטה פסיכולוגי

איסוף מידע פסיבי אינו סוף הסיפור. באופן הולך וגובר הרשתות החברתיות שולטות במידע שאנחנו צורכים. מה שאנחנו רואים בניוזפיד "נאצר" בידי אלגוריתמים עלומים, שמחליטים אילו מאמרים פוליטיים אנחנו קוראים, אילו טריילרים של סרטים אנחנו רואים, עם מי אנחנו שומרים על קשר, ממי נקבל פידבק על הדעות שאנחנו מביעים. ואחרי שנים של חשיפה, האוצרות האלגוריתמית של התוכן שאנחנו צורכים מעניקה לאלגוריתמים שמנהלים אותה כוח על חיינו — על מי אנחנו, מי נהפכנו להיות. אם פייסבוק מחליטה במשך שנים אילו חדשות נראה (אמיתיות או מזויפות), לאילו עדכונים פוליטיים ניחשף ומי ייחשף לשלנו, יש לה שליטה בהשקפת עולמנו ודעותינו הפוליטיות.

הביזנס של פייסבוק טמון ביכולת להשפיע על אנשים. זה השירות שהיא מוכרת ללקוחותיה, המפרסמים. לכן פייסבוק יצרה מנוע אלגוריתמי מכוונן היטב שעושה בדיוק את זה. המנוע לא רק מסוגל להשפיע על דעתך על מותג מסוים, או העדפתך איזה רמקול לקנות. הוא יכול להשפיע על מצב הרוח שלך, לכוון את התוכן שבו הוא מזין אותך כדי שתכעס או שתשמח. יכול להיות שהוא גם יכול להשפיע על תוצאות הבחירות.

מערכת הדירוג החברתי בסין. AI מאפשרת צורות חסרות תקדים של טוטליטריות

מערכת הדירוג החברתי בסין. AI מאפשרת צורות חסרות תקדים של טוטליטריות

המניפולציות של האלגוריתם

ההתנהגות האנושית כבעיית אופטימיזציה

בקיצור, הרשתות החברתיות יכולות למדוד כל דבר הקשור אלינו ולשלוט במידע שאנחנו צורכים. וזה רק צובר תאוצה. כשיש לך גישה גם לתפיסה וגם לפעולה, יש לך בעיית AI. אתה יכול לבנות לולאת אופטימיזציה להתנהגות האנושית, שבה אתה בוחן את מצבן של המטרות שלך ומכוונן ללא הפסקה איזה מידע אתה מספק להן, עד שאתה מתחיל לראות את הדעות וההתנהגויות שאליהן כיוונת. תת־קבוצה רחבה בתחום ה־AI, ובעיקר למידה מבוססת חיזוקים, עוסקת בפיתוח אלגוריתמים שפותרים בעיות אופטימיזציה כאלה באופן היעיל ביותר האפשרי, כדי לסגור את הלולאה ולהשיג שליטה מלאה במטרה — במקרה זה, אנחנו. כשאנחנו מעתיקים את חיינו לממלכת הדיגיטל, אנו נהפכים לחשופים לכוחות השולטים בה, אלגוריתמים של AI.

כל זה קל יותר בזכות העובדה שהמוח האנושי רגיש מאוד למניפולציות חברתיות פשוטות. חשבו למשל על וקטורי ההתקפה הבאים:

Þ חיזוק זהות: זהו תכסיס ישן שממונף מאז הפרסומות הראשונות בהיסטוריה, ועדיין עובד טוב כמו אז. הוא מבוסס על יצירת אסוציאציה בין דעה מסוימת לסמנים שאנחנו מזדהים איתם (או שהיינו רוצים להזדהות איתם), מה שגורם לנו להזדהות אוטומטית עם הדעה שהוגדרה יעד. בהקשר של אופטימיזציית AI בצריכת רשתות חברתיות, אלגוריתם שליטה יכול להבטיח שנראה תוכן (חדשות או פוסטים של חברים) שבו הדעות שהוא רוצה שנאמץ מחוברות לסמני הזהות שלנו, ולהפך בכל הנוגע לדעות שהאלגוריתם רוצה שנתרחק מהן.

- חיזוק חברתי שלילי: אם אתה מעלה פוסט ובו דעה שאלגוריתם השליטה לא רוצה שתחזיק בה, המערכת יכולה לבחור להראות את הפוסט רק למי שמחזיקים בדעה ההפוכה (מכרים, זרים או בוטים), והם ימתחו עליה ביקורת חריפה. כשהדפוס הזה חוזר פעמים רבות, סביר שתגובת נגד חברתית כזאת תרחיק אותך מהדעות המקוריות שלך.

- חיזוק חברתי חיובי: אם הפוסט שלך מציג דעה שהאלגוריתם רוצה שתפיץ, הוא יכול לבחור להראות אותו רק למי שיעשו לו לייק. זה יחזק את האמונה שלך וייצור אצלך את הרושם שאתה חלק מרוב תומך.

- דגימה מוטה: יכול להיות גם שהאלגוריתם ייטה יותר להראות לך פוסטים מחברים (או מכלי תקשורת) שתומכים בדעות שהוא רוצה שתחזיק בהן. בבועת מידע כזאת, תהיה תחת הרושם שהדעות האלה זוכות לתמיכה רחבה יותר מכפי שהן זוכות לה במציאות.

- פרסונליזציה של הטיעון: ייתכן שהאלגוריתם יזהה שהחשיפה לתכנים מסוימים בקרב אנשים בעלי פרופיל פסיכולוגי דומה לשלך תביא לשינוי הדעה שבו הוא מעוניין. במקרה כזה, ייתכן שהוא יראה לך תוכן שאמור ליצור את ההשפעה המקסימלית על מישהו עם דעות וניסיון חיים כמו שלך. בטווח הארוך, ייתכן שהאלגוריתם אפילו יוכל לייצר מאפס תוכן בעל אפקטיביות מקסימלית, מותאם לך אישית.

מארק צוקרברג מעיד בסנאט בסוגיית הפרטיות של פייסבוק. יכול להיות שהחברה רק מנסה למקסם את מעורבות המשתמשים, אבל הכלים שהיא מפתחת נחטפים למטרות פוליטיות צילום: איי אף פי

מארק צוקרברג מעיד בסנאט בסוגיית הפרטיות של פייסבוק. יכול להיות שהחברה רק מנסה למקסם את מעורבות המשתמשים, אבל הכלים שהיא מפתחת נחטפים למטרות פוליטיות צילום: איי אף פי

מפרספקטיבה של אבטחת מידע, אפשר לקרוא לכל אלה נקודות תורפה, חולשות ידועות שאפשר לנצל כדי להשתלט על מערכת. במקרה של המוח האנושי, אי אפשר לתקן את נקודות התורפה האלה. כך אנחנו עובדים, הן בדנ"א שלנו. המוח האנושי הוא מערכת סטטית ורגישה, שתמצא את עצמה תחת מתקפה גוברת מאלגוריתמים של AI שהולכים ומחכימים, ושיש להם ראייה מלאה של כל מה שאנחנו עושים או מאמינים בו וגם שליטה מלאה במידע שאנחנו צורכים.

איך העולם עוד לא התהפך

תמונת המצב הנוכחית

במפתיע, מניפולציה נרחבת על האוכלוסייה, בייחוד שליטה פוליטית, על ידי שימוש באלגוריתמים של AI האחראים לתזונת המידע שלנו לא מחייבת בינה מלאכותית מתקדמת. לא צריך AI סופר־אינטליגנטית עם מודעות עצמית כדי שמניפולציה כזאת תהיה איום חמור — ייתכן שדי בטכנולוגיה הקיימת. החברות שמפעילות רשתות חברתיות עוסקות בתחום זה שנים, עם תוצאות מרשימות. יכול להיות שהן רק מנסות למקסם את ה"מעורבות" של המשתמשים ולהשפיע על החלטות קנייה, לא לעשות מניפולציות על השקפת עולמנו, אבל הכלים שהן מפתחות נחטפים למטרות פוליטיות, כפי שראינו במשאל על הברקזיט ובבחירות לנשיאות ארצות הברית. זו כבר המציאות שלנו. אבל אם מניפולציה נרחבת אפשרית כיום, בתיאוריה, איך העולם עוד לא התהפך? אני חושב שזה משום שאנחנו ממש גרועים ב־AI. אבל ייתכן שזה עומד להשתנות.

עד 2015 כל האלגוריתמים של פרסום ממוקד פעלו על רגרסיה לוגיסטית פשוטה, ובמידה רבה זה נכון גם כיום, כי רק השחקניות הגדולות עברו בינתיים למודלים מתקדמים יותר. רגרסיה לוגיסטית, אלגוריתם שקדם לעידן המחשוב, היא אחת השיטות הבסיסיות יותר להתאמה אישית, והיא הסיבה לכך שכל כך הרבה פרסומות שאנחנו רואים ברשת הן לגמרי לא רלבנטיות. גם הבוטים של הרשתות החברתיות שנוצלו בידי גורמים עוינים כדי להשפיע על דעת הציבור מתבססים על AI במידה מוגבלת, אם בכלל. הם פרימיטיביים מאוד. לעת עתה.

למידת מכונה ו־AI מתקדמות במהירות, וההתקדמות הזו רק מתחילה לבוא לידי ביטוי באלגוריתמים ובוטים של המדיה החברתית. הלמידה העמוקה החלה לחדור לניוזפיד ולפרסום רק ב־2016. מי יודע מה יקרה בהמשך. פייסבוק משקיעה המון במחקר ופיתוח של AI במטרה מוצהרת להפוך למובילה בתחום; כשהמוצר שלך הוא ניוזפיד חברתי, איזה שימוש אתה יכול לעשות בעיבוד שפה טבעית ולמידה מבוססת חיזוקים?

אנו מתבוננים בחברה שבונה פרופילים פסיכולוגיים מפורטים ביותר של כמעט 2 מיליארד בני אדם, שמשמשת מקור חדשותי מרכזי לרבים מהם, שמבצעת ניסויים רחבי היקף במניפולציה על התנהגות, ושמתכוונת לפתח את טכנולוגיית ה־AI הטובה ביותר בעולם. אישית, זה מפחיד אותי. וקחו בחשבון שפייסבוק אינה בהכרח האיום המדאיג ביותר. חשבו, למשל, על השליטה של סין במידע כדי לאפשר צורות חסרות תקדים של טוטליטריות, כגון מערכת הדירוג החברתי שלה. רבים מעדיפים לחשוב שתאגידי ענק הם השליטים הכל־יכולים של העולם המודרני, אבל הכוח שבידי התאגידים האלה מתגמד לעומת זה של הממשלות. אם הן יקבלו שליטה אלגוריתמית במוח שלנו, ממשלות עלולות להפוך לשחקניות מסוכנות בהרבה מתאגידים.

אז מה אנחנו יכולים לעשות בעניין? איך אנחנו יכולים להגן על עצמנו? כטכנולוגים, מה אנחנו יכולים לעשות כדי להדוף את הסיכון למניפולציית המונים באמצעות הניוזפיד שלנו?

הפגנה נגד פייסבוק במקביל לעדותו של צוקרברג צילום: איי פי

הפגנה נגד פייסבוק במקביל לעדותו של צוקרברג צילום: איי פי

תנו לנו לשלוט באלגוריתמים

עוד צד למטבע: מה AI יכולה לעשות עבורנו

חשוב לציין שקיומו של האיום הזה לא אומר שכל פעילות אוצרות של אלגוריתמים היא רעה, או שכל פרסום ממוקד הוא בעייתי. רחוק מכך. שניהם יכולים לשרת מטרות יקרות ערך.

עם עלייתם של האינטרנט וה־AI, השימוש באלגוריתמים לניהול תזונת המידע שלנו אינו רק מגמה בלתי נמנעת, הוא רצוי. כשחיינו נהפכים לדיגיטליים יותר ויותר ומקושרים והעולם נהפך לעתיר מידע, כולנו זקוקים ל־AI שתשמש ממשק שלנו עם העולם. בטווח הארוך, חינוך והתפתחות אישית יימנו עם השימושים החשובים ביותר של AI — וזה יקרה בדינמיקה הפוכה כמעט לחלוטין מזו של הניוזפיד מונחה ה־AI המרושע, זה שמנסה לעשות עליך מניפולציות. לניהול מידע אלגוריתמי יש פוטנציאל עצום לעזור לנו, להעצים אנשים בדרך למימוש הפוטנציאל שלהם ולסייע לחברה לנהל את עצמה טוב יותר.

העניין אינו בינה מלאכותית כשלעצמה. העניין הוא שליטה.

במקום לתת לאלגוריתמים של הניוזפיד לעשות מניפולציות על המשתמש למען מטרות כמו שינוי דעותיו הפוליטיות או בזבוז מקסימלי של זמנו, עלינו להפוך את המשתמש לאחראי למטרות שעבורן האלגוריתם עובד. אחרי הכל, אנחנו מדברים על החדשות שלך, השקפת העולם שלך, החברים שלך, החיים שלך — ההשפעה שיש לטכנולוגיה עליך צריכה באופן טבעי להיות בשליטתך. אלגוריתמים לניהול מידע לא צריכים להיות כוח מסתורי שהושת עלינו כדי לשרת מטרות שמנוגדות לאינטרסים שלנו; במקום זאת, הם צריכים להיות כלי בידיים שלנו. כלי שאנחנו יכולים להשתמש בו למען המטרות שלנו, למשל חינוך וצרכים אישיים, לא לבידור.

הנה רעיון. כל ניוזפיד אלגוריתמי עם יכולת הסתגלות גדולה חייב:

- לחשוף מהן המטרות שעבורן נערכה האופטימיזציה של האלגוריתם, ואיך המטרות האלה משפיעות על תזונת המידע שלנו.

- לספק כלים אינטואיטיביים שיאפשרו למשתמשים לקבוע לעצמם את המטרות. למשל, צריכה להיות לך אפשרות להגדיר את הניוזפיד באופן שיאפשר לך מקסימום למידה והתפתחות אישית בתחומים ספציפיים.

- להציג, באופן גלוי לעין בכל רגע, כמה זמן אתה כבר גולל את הפיד.

- להציע כלים שמאפשרים לך לשלוט במשך הזמן שאתה מבלה בפיד, כגון הגבלת זמן יומית שלאחריה האלגוריתם ינסה להוריד אותך מהפיד.

עלינו לבנות AI שתשרת בני אדם, לא שתעשה עליהם מניפולציות בשביל רווח כספי או פוליטי. מה אם האלגוריתמים של הניוזפיד לא היו עובדים כמו מפעילי קזינו או תועמלנים? מה אם במקום זאת הם היו דומים יותר למנטור או לספרנית טובה, מישהו שמשתמש בהבנה חדה של הפסיכולוגיה שלך — ושל מיליוני אנשים דומים — כדי להמליץ לך על הספר המתאים ביותר להשגת היעדים ולצמיחה שלך. סוג של כלי ניווט לחיים — AI שיכולה להדריך אותך אל הנתיב האופטימלי בדרך למקום שאליו אתה רוצה להגיע. אתה יכול לדמיין התבוננות על החיים שלך מבעד לעדשות של מערכת שראתה מיליוני חיים מתפתחים? או כתיבה של ספר יחד עם מערכת שקראה את כל הספרים? או מחקר שייעשה בשיתוף מערכת שרואה את כל המידע האנושי הקיים כיום?

במוצרים שבהם יש לך שליטה מלאה ב־AI, אלגוריתם מתוחכם יהיה לא איום כי אם רווח נטו, שיאפשר לך להשיג את יעדיך באופן יעיל יותר.

מה התעשייה צריכה לעשות

יצירת אנטי־פייסבוק

ה־AI תהיה הממשק שלנו עם העולם. זה יכול להעצים בני אדם ולתת להם שליטה רבה יותר בחייהם, או להביא לאיבוד שליטה מוחלט.

לרוע המזל, הרשתות החברתיות צועדות כרגע בדרך הלא נכונה. אבל עדיין לא מאוחר מדי להפוך את הכיוון.

כתעשייה, עלינו לפתח מוצרים ושווקים שבהם התמריצים תומכים בלהעניק למשתמש את השליטה באלגוריתמים המשפיעים עליו, במקום בלהשתמש ב־AI לניצול המוח שלו לרווח כלכלי או פוליטי. אנחנו צריכים לשאוף למוצרים שיהיו האנטי־פייסבוק.

בעתיד הרחוק מוצרים כאלה יגיעו כנראה כסייעני AI: מנטורים דיגיטליים שתוכנתו כדי לסייע לך, להעניק לך שליטה במטרות שלהם באינטראקציות איתך. כרגע אפשר לראות במנועי החיפוש דוגמה מוקדמת ופרימיטיבית של ממשקי מידע מונחי AI שבהם אנחנו משתמשים למטרות ספציפיות במקום כאלה שרוצים לחטוף את המרחב המנטלי שלנו. חיפוש הוא כלי שבו אתה משתמש באופן מכוון כדי להגיע ליעדים ברורים, להבדיל מפיד פסיבי מופעל תמידית שבוחר מה להראות לך. אתה אומר לו מה לעשות עבורך. ובמקום לחתור לבזבוז מקסימלי של הזמן שלך, מנוע חיפוש מנסה לצמצם את הזמן שבין שאלה לתשובה, בין בעיה לפתרון.

ייתכן שתאמרו שכיוון שמנוע החיפוש הוא עדיין רובד AI בינינו לבין המידע שאנו צורכים, הרי שהוא יכול להטות את התוצאות כדי לבצע עלינו מניפולציות. נכון, בכל אלגוריתם לניהול מידע טמונה סכנה. ואולם בניגוד גמור לרשתות החברתיות, במקרה הזה תמריצי השוק עומדים בקנה אחד עם צורכי המשתמשים, ודוחפים את מנועי החיפוש להיות רלבנטיים ואובייקטיביים ככל האפשר. ובמנוע חיפוש יש שטח פנים קטן יותר למתקפות פסיכולוגיות מאשר בניוזפיד.

האיום ששרטטנו כאן מצריך את קיומם של המאפיינים הבאים במוצר:

- משלב תפיסה ופעולה: לא זו בלבד שעל מוצר לשלוט במידע שהוא מציג לנו (חדשות ועדכונים חברתיים), הוא צריך גם להיות מסוגל "לתפוס" את המצב המנטלי שלך באמצעות לייקים, הודעות ועדכוני סטטוס. בלי תפיסה ופעולה גם יחד, אי אפשר לבנות שום לולאת למידה המבוססת על חיזוקים. פיד לקריאה בלבד מסוכן רק כשהוא משמש כלי תעמולה מהסוג הקלאסי.

- מרכזי בחיינו: המוצר צריך להיות מקור מידע מרכזי, והמשתמש הממוצע צריך לבלות בו שעות בכל יום. פיד משני וספציפי (למשל ההמלצות באמזון) אינו איום ממשי.

- בעל רכיב חברתי, שמאפשר מערך רחב ואפקטיבי יותר של וקטורים לשליטה פסיכולוגית (בייחוד חיזוק חברתי). ניוזפיד שאינו אישי משפיע על דעותינו רק במעט.

- נהנה מתמריצים עסקיים המכוונים למניפולציה על המשתמשים ולהשארתם במוצר יותר זמן.

לרוב המוצרים לניהול מידע המבוססים על AI אין את כל המאפיינים האלה. מנגד, ברשתות החברתיות רואים תמהיל מפחיד של גורמי סיכון. כטכנולוגים עלינו להעדיף מוצרים שלא כוללים את המאפיינים הללו ולהדוף את המוצרים המשלבים את כולם, ולו רק בשל הפוטנציאל לניצול לרעה. בנו מנועי חיפוש וסייענים דיגיטליים, לא ניוזפיד חברתי. הפכו את מנועי ההמלצות שלכם לשקופים, קלים להתאמה וקונסטרוקטיביים במקום למכונות הימורים שממקסמות את "מעורבות" הגולשים ומבזבזות שעות מזמנם של בני האדם. נצלו את המומחיות שלכם בעיצוב חוויית משתמש ובינה מלאכותית כדי לאפשר לאנשים להשתמש במוצר שלכם בתנאים שלהם.

ומעבר לכך, עלינו לחנך את המשתמשים בנושאים הללו, כדי שהם ידחו מוצרים מניפולטיביים וייצרו מספיק לחץ שוק כדי שהתמריצים של תעשיית הטכנולוגיה יתאימו לאלו של הצרכנים.

זמן להפעיל את המצפן המוסרי

סיכום: ההתפצלות שבהמשך הדרך

אם כן, הרשתות החברתיות לא רק יודעות עלינו מספיק כדי ליצור מודלים פסיכולוגיים רבי עוצמה, הן גם שולטות במידה גוברת בצריכת התוכן שלנו. יש להן גישה לשורה של נקודות תורפה פסיכולוגיות אפקטיביות שמאפשרות מניפולציות על האמונות, התחושות והמעשים שלנו. כך, אלגוריתם AI מתקדם יכול לפעול ביעילות על הדעות וההתנהגויות שלנו.

השימוש ב־AI כממשק שלנו למידע אינו, כאמור, הבעיה כשלעצמה; עם תכנון נכון, ממשקי AI יכולים להועיל מאוד ולהעצים את כולנו. המפתח הוא בכך שהמשתמשים יקבלו שליטה מלאה במטרות האלגוריתם וישתמשו בו כדי להשיג את היעדים שלהם (כפי שאנחנו משתמשים במנוע חיפוש). כטכנולוגים חלה עלינו אחריות להתנגד למוצרים ששוללים מאיתנו שליטה ולהקדיש את המאמצים שלנו לבניית ממשקי מידע שהופכים את המשתמש לאחראי. אל תשתמשו ב־AI ככלי למניפולציה על המשתמשים שלכם; תנו להם בינה מלאכותית ככלי להשגת שליטה גדולה יותר בחייהם.

נתיב אחד מוביל למקום שמפחיד אותי, האחר מוביל לעתיד הומני יותר. עדיין יש לנו זמן לבחור בנתיב הטוב. אם אתם עובדים בפיתוח טכנולוגיות כאלה, זכרו זאת. ייתכן שהכוונות שלכם אינן זדוניות. ייתכן שפשוט לא אכפת לכם. ייתכן שהמניות שקיבלתם מהחברה חשובות לכם יותר מהעתיד המשותף שלנו. אבל בין שאכפת לכם או לא, כיוון שיש לכם חלק בעיצוב העולם הדיגיטלי שלנו, הבחירות שלכם משפיעות על כולנו. וייתכן שבסופו של דבר תיאלצו לשאת באחריות להן.